记得小时候看过一则纪录片,里面讲解了电影幕后人员的分工。而摄影师往往会配一位「跟焦员」的跟班,这就好似每个打高尔夫的都会有一个球童,每个开拉力的都会有一个导航员,几乎成为电影行业的标配。

跟焦员主要只保证镜头的焦点(焦平面)符合摄影导演的需求,也就是确保主体清晰。

听起来似乎相当简单的工作,却并非是每个人都能胜任,它对焦点的移动速度、切换准确性都有着很高的要求。没有常年累月的积累形成肌肉记忆,很难达到炉火纯青的地步,也很难准确的在不同的焦点之间切换。

即使到了如今相机的自动对焦技术有了十足的进步,但电影工业依旧万变不离其宗,依旧全手动,摄影师依然有那么个「跟班」。

焦点的移动,会突出人物,也可能会凸显环境,而人眼的本能是追踪清晰的主体,焦点的变化便会引导观众注意力随着焦点而转移,从而实现叙事或者氛围烘托,已然成为电影的一则语言。扎导对此应该很有发言权。

如果普通人想要拍出类似这种「电影」的效果,不算后期的话,一台全画幅相机,一个大光圈镜头即可,但从经济性和普适性上来说,可以打个负分了。

而今年的 iPhone 13 全系列上的「电影效果模式」可能会是一个新选择。

电影效果模式,就是视频人像模式

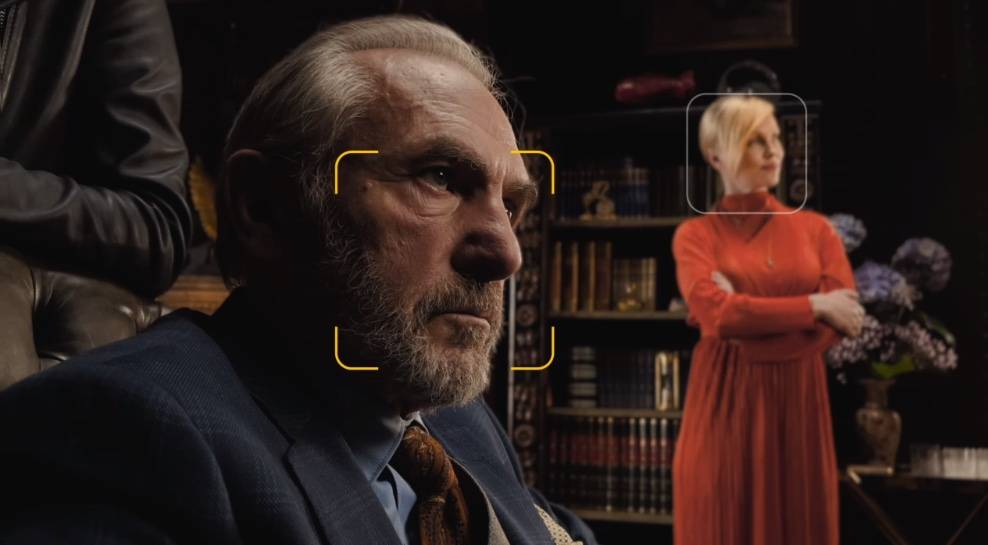

关于 iPhone 13 所有的 TVC 中,印象最深的依旧是《Whodunnit》和《谁偷了我的 iPhone》,电影效果模式的加入,让整个影片的故事感提升了很多,当然后者的演员也是一大亮点。

▲ 强烈推荐看完整片段

其实,早在苹果 9 月 15 日推出 iPhone 13 之前,就有相应的传闻流出,表示苹果会推出「视频人像」功能,彼时并没有觉得会有多「有用」。

但当看到《Whodunnit》的广告示范片,以及我们拿到 iPhone 13 系列后,身体力行的「复现」了一段之后,才渐渐明白「电影效果模式」出现的意义堪比 iPhone 7 Plus 上的「人像模式」。

它们都不是以经典的光学技术做底,而是另寻他法。曾经的「人像模式」与现在的「电影效果模式」都基于多镜头的视差,而非是 LiDAR,这也就解释了为何 iPhone 13 全系都支持,而非仅限于 Pro 系列。

目的很明显,就是想与当年的「人像模式」一样去普及。

▲ 你脸大,你赢了.

也是基于此,iPhone 13 全系的「电影效果模式」拍摄效果接近,而识别主体来模拟景深,会以人脸为主,多张人脸下,以大为优先级。

它无法识别物体与动物,想要切换,需要人工干预。而在人山人海的场景下,iPhone 13 可以同时识别多张人脸,但会频繁的切换焦点,此时也需要干预,选出你想关注的人,或者直接长按锁定。

另外,「电影效果模式」是苹果首次推出,自然也有很多不少的限制。一是抠图不够精细,人物的边缘有时会「穿帮」,以及最高仅可记录 1080p 30p 视频,iPhone 13 Pro Max 1TB 版也是如此。

不过,在上述的限制之下,iPhone 13 全系的「电影效果模式」依旧能够兼顾杜比视界 HDR 编码,也算是苹果权衡的一个选择。

「电影效果模式」其实诞生自好奇心

以往来说,新功能的出现很多是需要洞察需求以及从用户反馈中得来,但站在金字塔顶端的苹果更多的是按照自己的理解和节奏去做产品。

▲ 苹果人机界面设计师 Johnnie Manzari. 图片来自:Getty Images

在接受科技媒体 TechCrunch 的主编马修(Matthew Panzarino)采访时,苹果人机界面设计师约翰(Johnnie Manzari)就道出了电影效果模式诞生的始末。

「电影效果模式」并非是从功能本身出发,而只是因为设计部门好奇电影制作的过程,以此为出发点,去研究、学习电影的摄影技术,从而实现接近真实的焦点转换和一些光学特性。

同时,约翰表示开发「电影效果模式」时与出现在 iPhone X 上的摄影室光效人像照片功能有些类似。

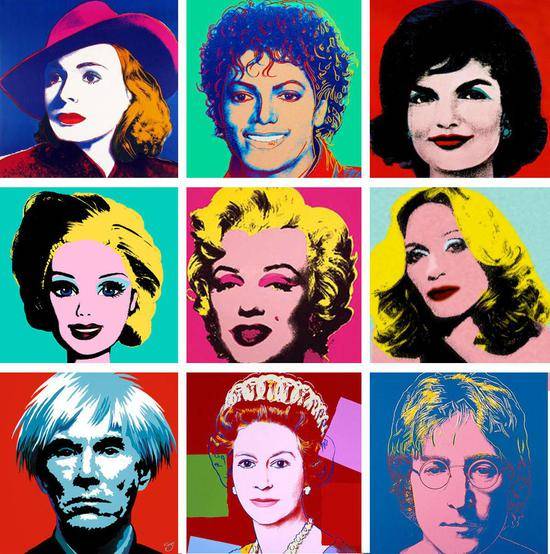

从经典肖像艺术家安迪·沃霍尔(Avedon Warhol)的人像作品,巴洛克绘画艺术画家伦勃朗,以及中国的工笔画中汲取经验并分析,从而运用在产品的算法之中。

▲ 安迪·沃霍尔艺术作品(左下一为本人).

「电影效果模式」也是类似的过程,苹果团队先是与世界级的摄像师探讨取经,并观看了大量的电影。

在此过程中,我们发现了电影制作过程中的一些亘古不变的趋势。焦点之间的变化是一个电影行业通用的语言,我们需要准确的了解它们的使用方式和时机。

▲「电影效果模式」中的焦点转换.

于是,约翰与团队成员一起与摄影导演、第一摄影助理密切合作,从而了解这一切背后的机理。浅景深的运用可以引导观众们的注意力,可以助力故事的描绘。

只是,「变焦」是为专业人士准备的,普通人很难掌握其中的精准度,可谓是手上差之毫厘,观感上谬以千里。

在了解到跟焦员需要多年大量的练习,才能掌握实时的根据电影机与主体的位置来保证焦点不变的情况后,约翰与设计团队以及苹果都认为这项即将面向市场的「电影效果模式」会是一个很有竞争力的功能。

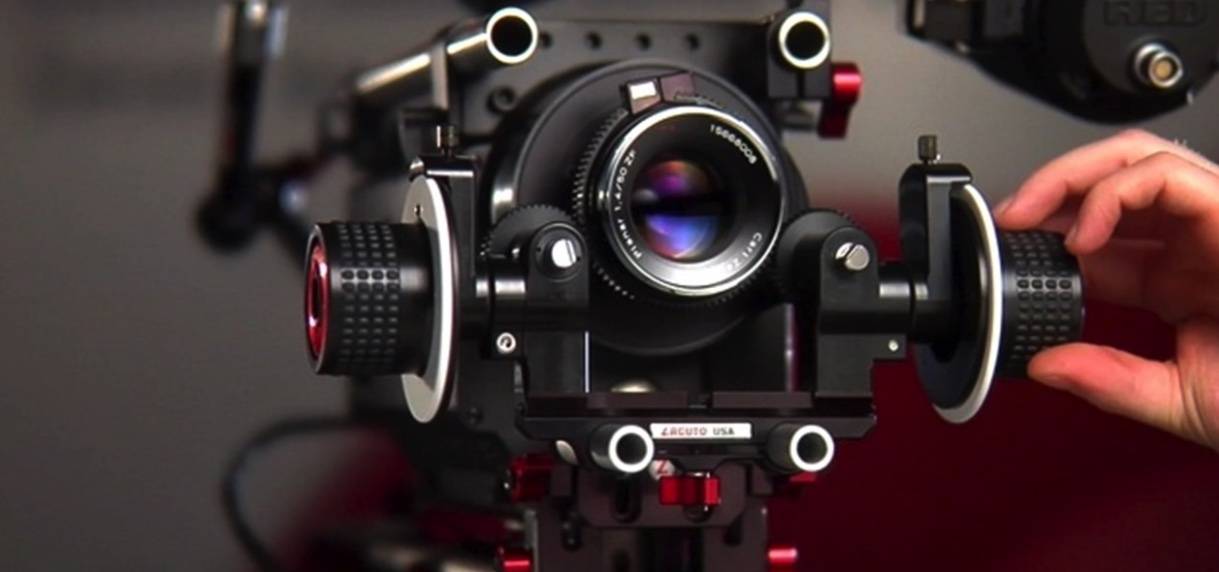

▲ 简答的跟焦设备

对于此,通过研究苹果把「电影效果模式」分解为两大部分,一是「寻找焦点」,二是如何平滑转移。

寻找焦点最终定为「凝视检测」,其实更接近人脸检测,以让观众们聚焦主角的移动,从而引导观众去快速了解故事。

而平滑转移则是约翰长期观察一位跟焦员所操作焦距控制轮而加入的特性,熟练的跟焦员会通过滚轮的控制来让焦点自然而稳定的转移,并且还会根据镜头的焦距与物体距离进行实时变化。

苹果在「电影效果模式」上花了很多时间来试图模拟这位跟焦员的手活,因此我们在用「电影效果模式」拍摄,在不同焦点切换时,并非机械式的快速推拉,而是有着较为明显的跟焦过程。

当然,「电影效果模式」也才刚刚发布,就如同「人像模式」一般,它还有不少可优化的地方。

这就好像你看到郎朗弹钢琴是如此的轻松写意,但你知道不可能用算法做到(只能去不断接近)他这种大师级的水准。

「电影效果模式」落地背后的功臣 A15

既然是通过算法「猜」出来的,那理论上「电影效果模式」可以通过 OTA 下放到其他的 iPhone 之中(比如 iPhone 12),只是可能会牺牲实时预览。但以苹果的思路,很难通过牺牲一些体验来把新功能下放。

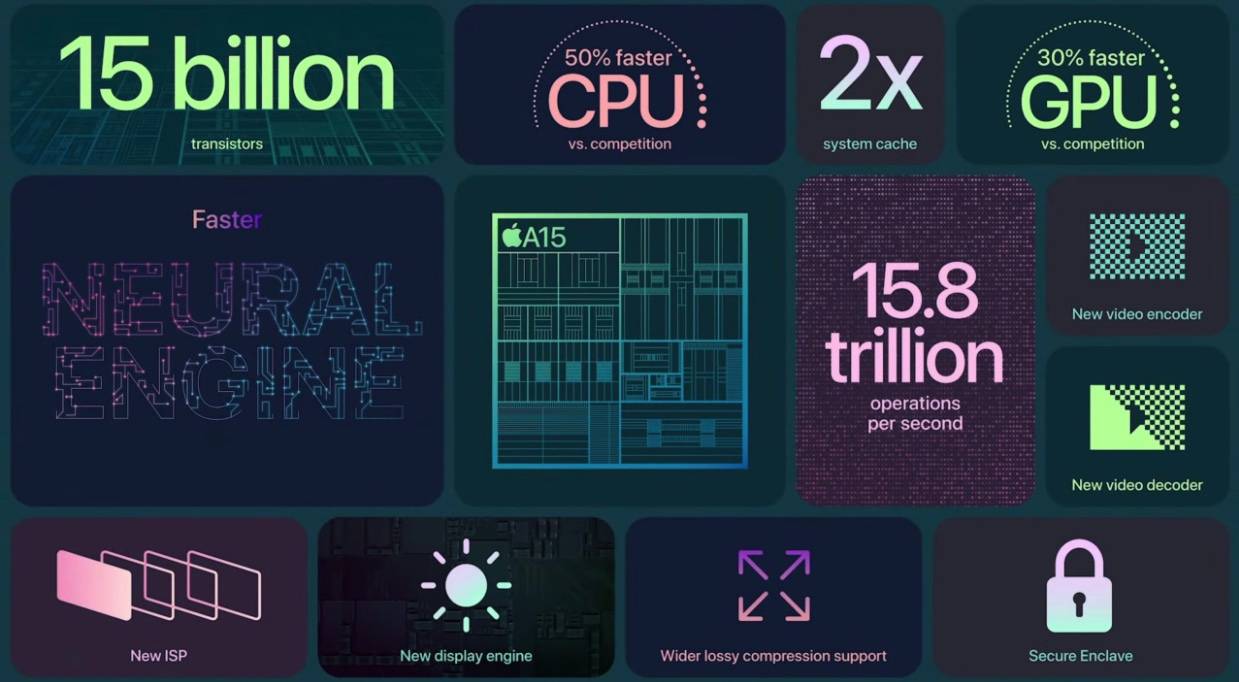

▲ A15 提升要点,注意 CPU、GPU 的提升是与竞争对手相比.

因此,「电影效果模式」会是 iPhone 13 全系列的一个暂时独享的功能,也会是 A 系芯片算力的一个门槛,也可能会成就新一代的 iPhone「钉子户」。

iPhone 营销副总裁凯安(Kaiann Drance)在采访中就表示让视频自带模拟景深比人像照片更具「挑战性」。

▲ iPhone 营销副总裁 Kaiann Drance.

视频需要随着被摄者移动而移动,需要实时防抖(数码加光学),并准确识别不同的场景、人物、动物、物体,因此对于神经引擎和机器学习来说,需要质量更高的深度数据,并且实时的渲染出来。

哦,还有实时对焦,以及对杜比视界 HDR 编码的支持。而这一切的背后都来自于 A15,可谓小小的年纪承担了全家的重任。

相对于 A15 的 CPU,在实测之中,GPU 性能提升明显,它或许采用了全新的架构,以及多堆了一颗核心。另外,A15 的神经网络引擎算力提升到了 15.8TOPS。

而这些硬件上的改进或许是跟本次 iPhone 13 全系在视频功能上提升不无关系。「电影效果模式」中包含的一些不同于静态照片的机器学习难题,相信在 A15 开发之时,约翰所在的人机交互设计团队就已经与芯片开发做过深入交流。

在 TechCrunch 的测试视频之中,他们还发现了 iPhone 13 系列的「电影效果模式」在识人的过程中,会运用冗余的传感器进行主体的预测。

马修女儿的后脑勺一出现在画面中,他手里的 iPhone 13 立刻就把焦点切换好了,就好像在舞台剧中,有一位全局掌控的导演一般,主角未登场,提前就备好了灯光,并引领观众一同期待她的出现。

针对「电影模式」的这个细节,苹果人机交互设计师约翰说到:

我们在观察电影制作时发现,跟焦员并非是等主角登场之后再去移动焦点,而是有一个预测过程。我们也通过冗余传感器,来通过机器学习来预测画面外人们的运动,当他们出现在画面的时候,焦点也已经在他们身上了。

乔布斯曾很喜欢说,苹果是处于技术与艺术的交叉点。

在 iPhone 13 系列发布之前,「人像模式」更像是一则技术术语,它给人的感觉是冰冷的。而「电影效果模式」,以及 TVC 的呈现,再到亲测,它不再冰冷,而带有了一定的温度。在深入了解「电影效果模式」背后的故事之后,它又带上了几分「拍摄的艺术」。

「电影效果模式」对于普通人而言,它可能没有这么深的意义,更像是瑞士军刀里的一则红酒起子,可能并非是最完美最省力,但却是在紧急时刻能堪大任的工具。

电影向我们展示了人类的情感和故事,如果你用对了正确的表达语言,就会被传达出去。而当下,我们努力了很久,让你的生活故事能在自己的手机上记录和演绎,我已经迫不及待地想看到人们用「电影效果模式」所书写的故事了。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

from 爱范儿 https://ift.tt/3i4a6ie

via IFTTT

没有评论:

发表评论