当我们使用 ChatGPT、文心一言和通义千问等等大语言模型支持的 AI 工具时,有一个必要条件:必需联网。

因为 AI 工具的运算在云端,并非电脑本地。但是在上游芯片厂商和终端厂商看来,有网环境下大模型固然强大,但也需要无需网络也能运行的端侧大模型来补充,端云结合,才是万全之策。

于是在 12 月 15 日的英特尔第一代酷睿 Ultra 正式发布活动上,我们看到了阿里云通义千问大模型成功适配英特尔酷睿 Ultra 平台,未来可在 PC 等端侧部署。

得益于第一代酷睿 Ultra 平台(代号 Meteor Lake)有着英特尔 40 年来最重大的处理器架构变革,即分离式模块架构,以及首次集成神经网络处理单元(NPU),部署在英特尔酷睿 Ultra 平台设备上的通义千问大模型能够大幅缩短了模型推理响应时间,平均加速可达 3 倍。

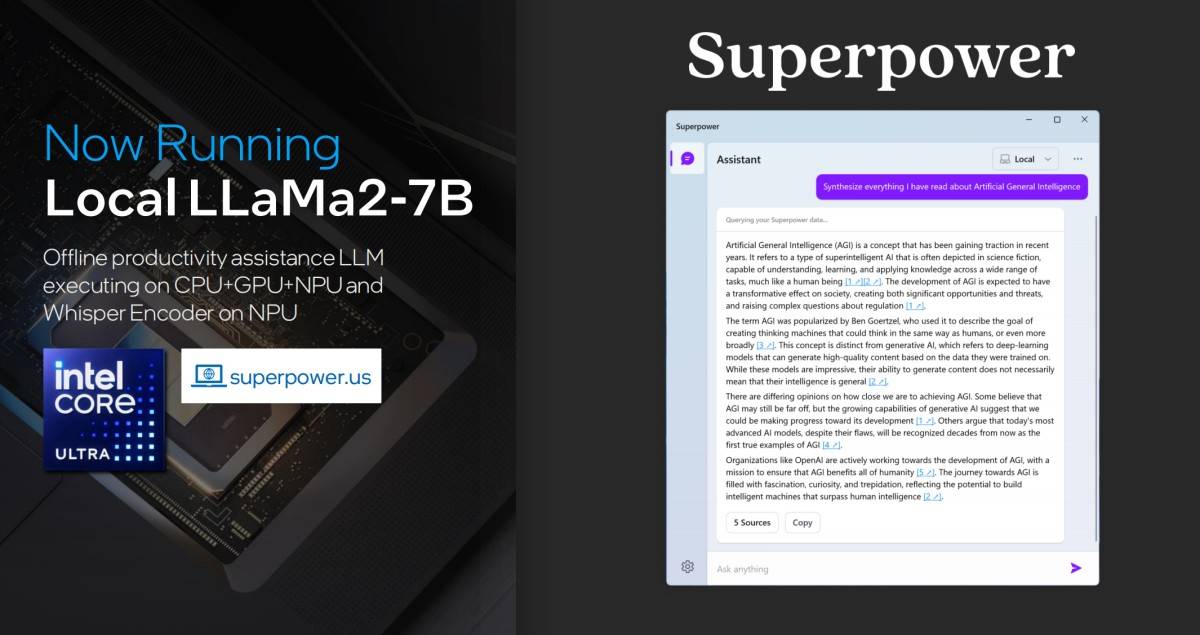

加上此前英特尔也测试出了来自 Meta 的 LLaMa2-7B 大模型在端侧无网运行的良好表现,AI PC 的概念,因为端侧大模型的逐渐落地,变得清晰起来。

自去年年底 ChatGPT 发布开始,大语言模型技术支持下的 AIGC 应用获得了极大的发展,这一波 AI 浪潮的主阵地便发生在 PC 上,因为 PC 在交互和呈现上,都更契合多数的 AIGC 应用,但是不管是 ChatGPT 还是 MidJourney,都需要联网使用,一旦没有网络,那我们便与 AI 断连。

因而,PC 想要真正进化为 AI PC,不仅是 AIGC 应用能方便地运行在上面,本身自己也需要有强悍的 AI 处理能力。

所以,阿里云通义千问大模型 Qwen-7B 成功适配英特尔酷睿 Ultra 平台,未来可在 PC 等端侧部署的新闻就有两层含义,和一个象征性意义了。

第一层含义,英特尔喊出 AI PC 口号,依仗的是什么?

在今年 9 月硅谷举办的 on 技术创新大会上,英特尔 CEO 帕特基辛格提出了 PC 的革命性概念——AI PC。

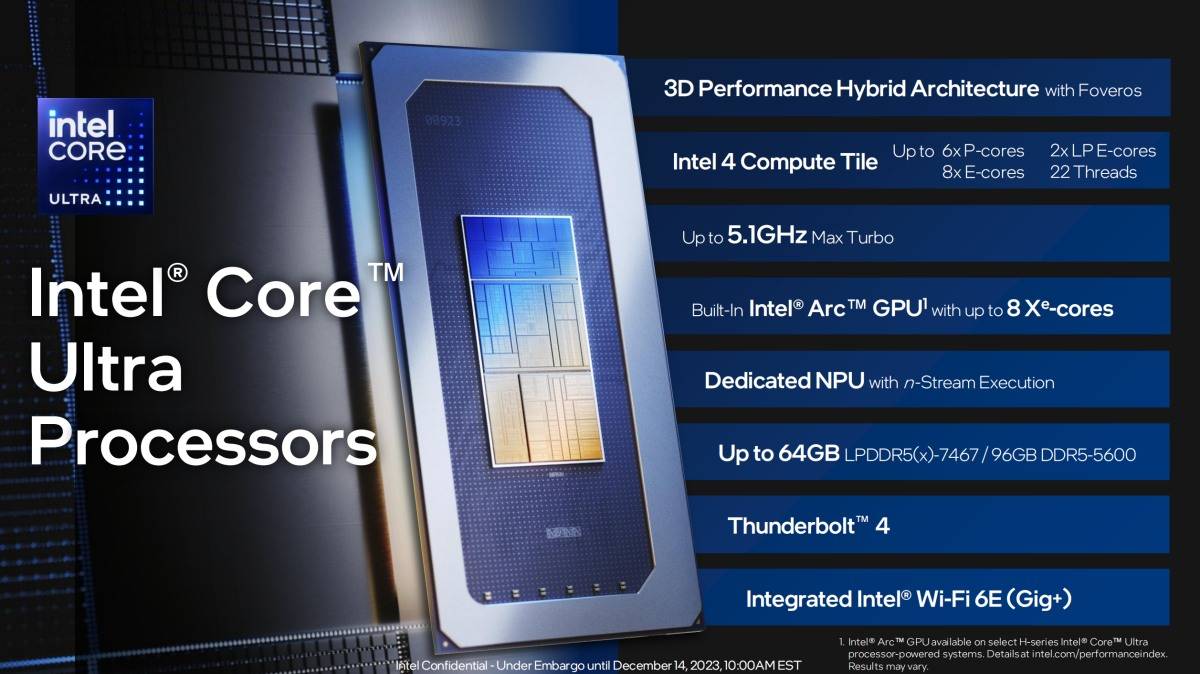

想要在 PC 上高效进行 AI 计算,运行 AI 应用,传统的 CPU+GPU 架构并非最优解,因而在第一代酷睿 Ultra 平台上,英特尔创新性地采用了分离式模块架构,这也是英特尔历史上最大的处理器结构变革,处理器将由计算模块、SoC 模块、图形模块以及 IO 模块这 4 个独立模块组成,并通过 Foveros 3D 封装技术连接:

计算模块(Compute Tile):采用了最新一代的能效核和性能核微架构以及增强的功能。该模块采用新一代的 Intel 4 制程工艺,在能耗比方面实现了重大进步。

SoC 模块(SoC Tile):创新的低功耗岛设计(Low Power Island),集成了神经网络处理单元(NPU),为 PC 带来了高能效的 AI 功能表现,并兼容 OpenVINO 等标准化程序接口,便于 AI 的开发及应用普及。新的低功耗能效核,进一步优化节能与性能间的平衡。SoC 模块还集成了内存控制器、媒体编解码处理和显示单元,支持 8K HDR 和 AV1 编解码器以及 HDMI 2.1 和 Display Port 2.1 标准。还支持 Wi-Fi 和 Bluetooth,包括 Wi-Fi 6E。

图形模块(GPU Tile):这款处理器集成了英特尔锐炫图形架构,能够在集成显卡中提供独立显卡级别的性能,支持光线追踪和 Intel XeSS。凭借图形功能的跃升和更高的能效表现,Meteor Lake 能够提供出色的每瓦性能表现。

IO 模块(IO Tile):包含出众的连接性,集成了 Thunderbolt 4 和 PCIe Gen 5.0。

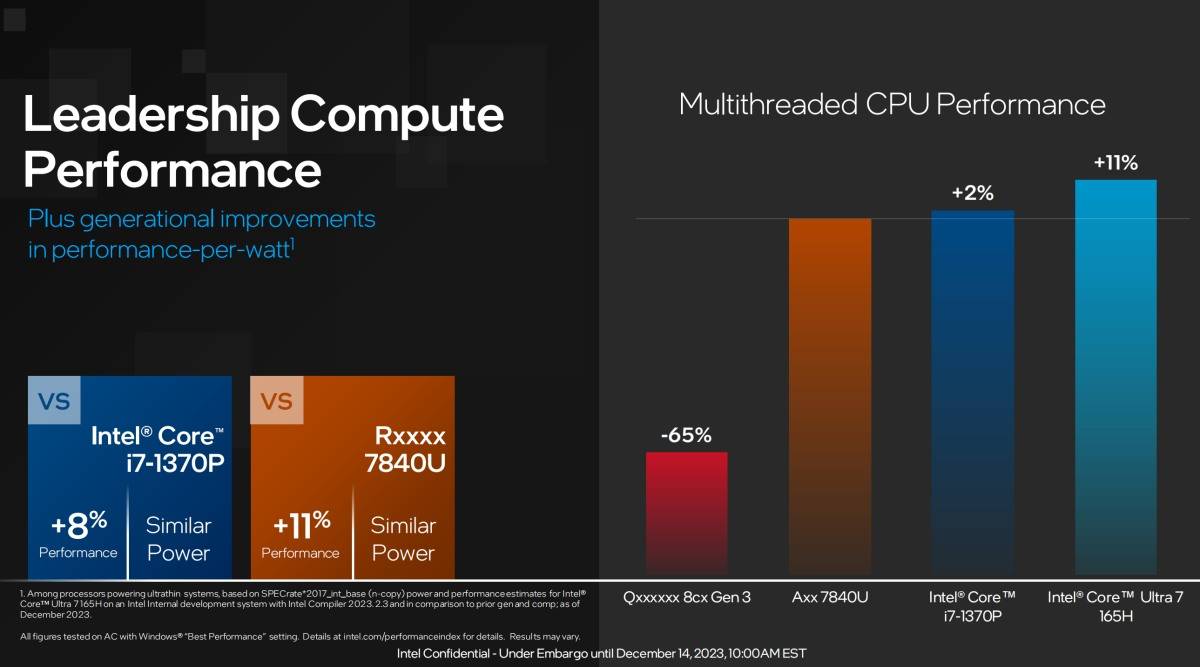

以酷睿 Ultra 7 165H 这款处理器(TDP 28W)为例,英特尔表示其多线程性能是高通骁龙 8cx Gen 3 的 3 倍有余,是直接竞争对手 AMD 7840U 的 1.11 倍。

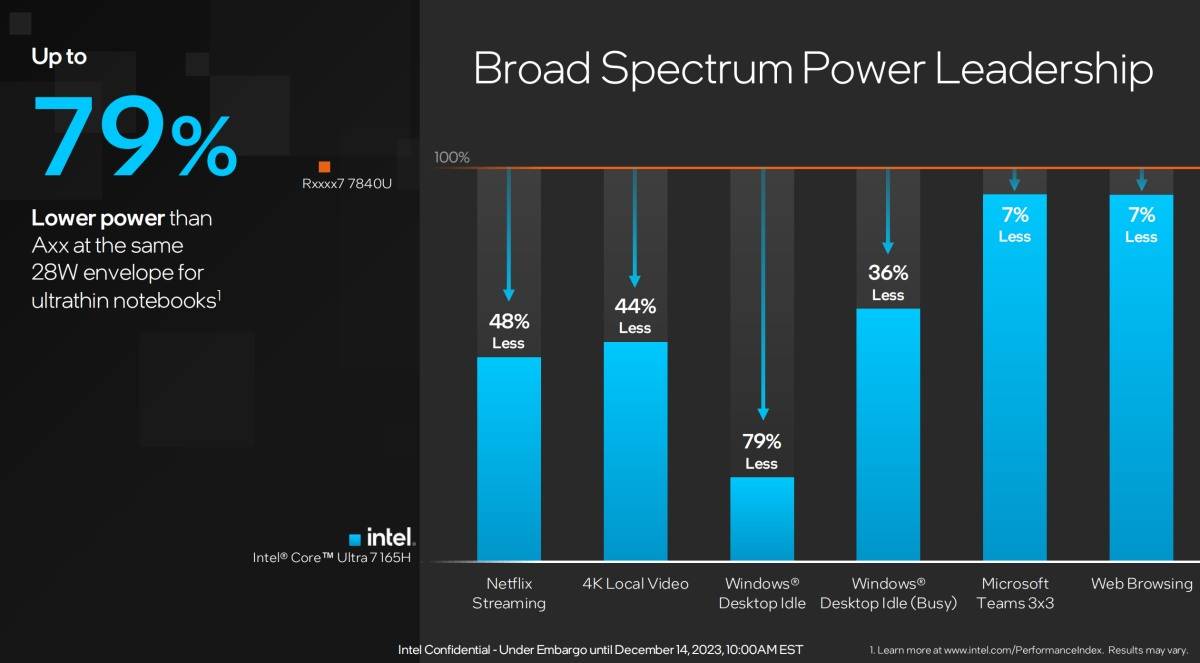

同时,英特尔表示,在多线程性能更优的情况下,酷睿 Ultra 7 165H 在各种场景的能效表现,也都优于 AMD 7840U。

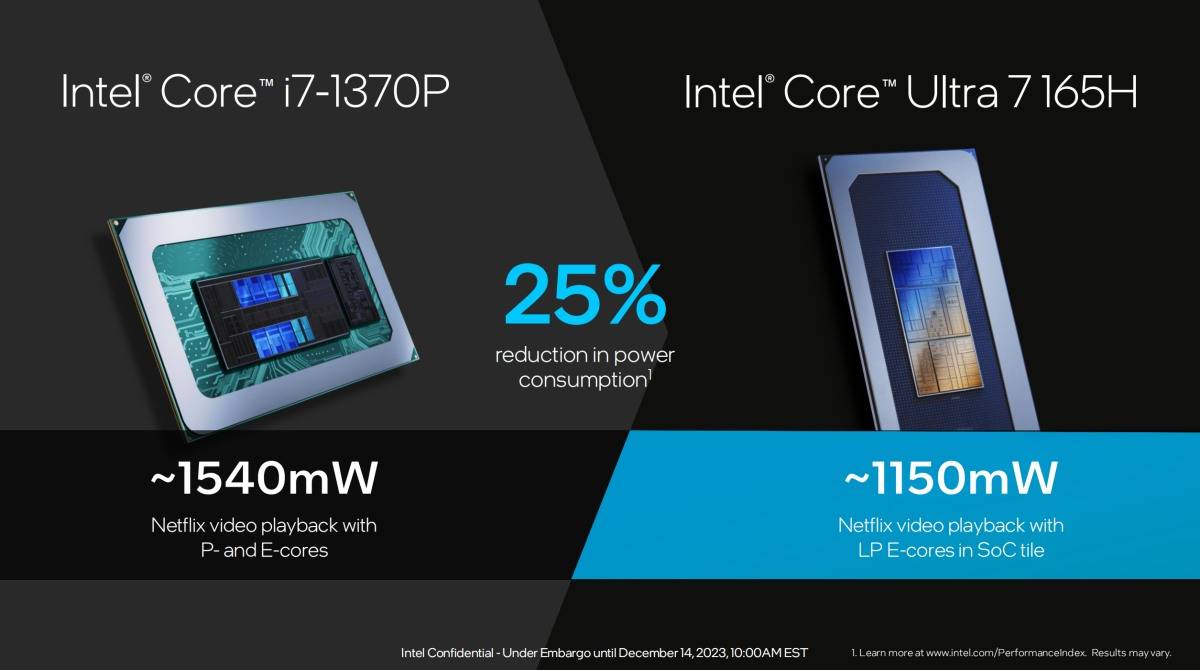

另外低功耗岛是一个非常有趣的设计,其中有 2 个 LPE-Cores 超低功耗核心,可以运行不那么需要响应速度的任务,比如在线播放等等,进一步降低功耗。之所以说这个设计有趣,是因为这两个超低功耗核心位于 SoC 模块,而不是计算模块。

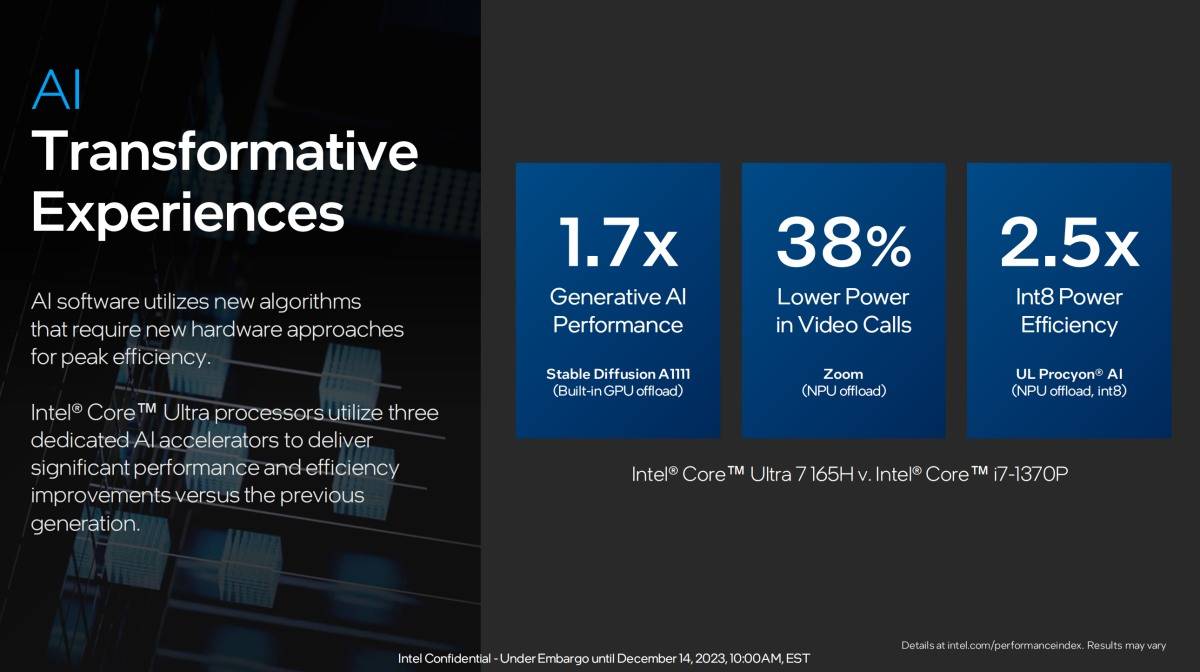

当然,最重要最显著的更新,自然是新增的 NPU 模块将主要承担起 AI 运算的责任,因为是针对人工智能加速的专项计算单元,NPU 机型 AI 计算时的优势是高性能低功耗,另外,低延迟高响应速度的 CPU 和高性能和高吞吐量的 GPU 也会负担起了 AI 算力的需求,三者协作,就构成了终端上的强大 AI 算力。

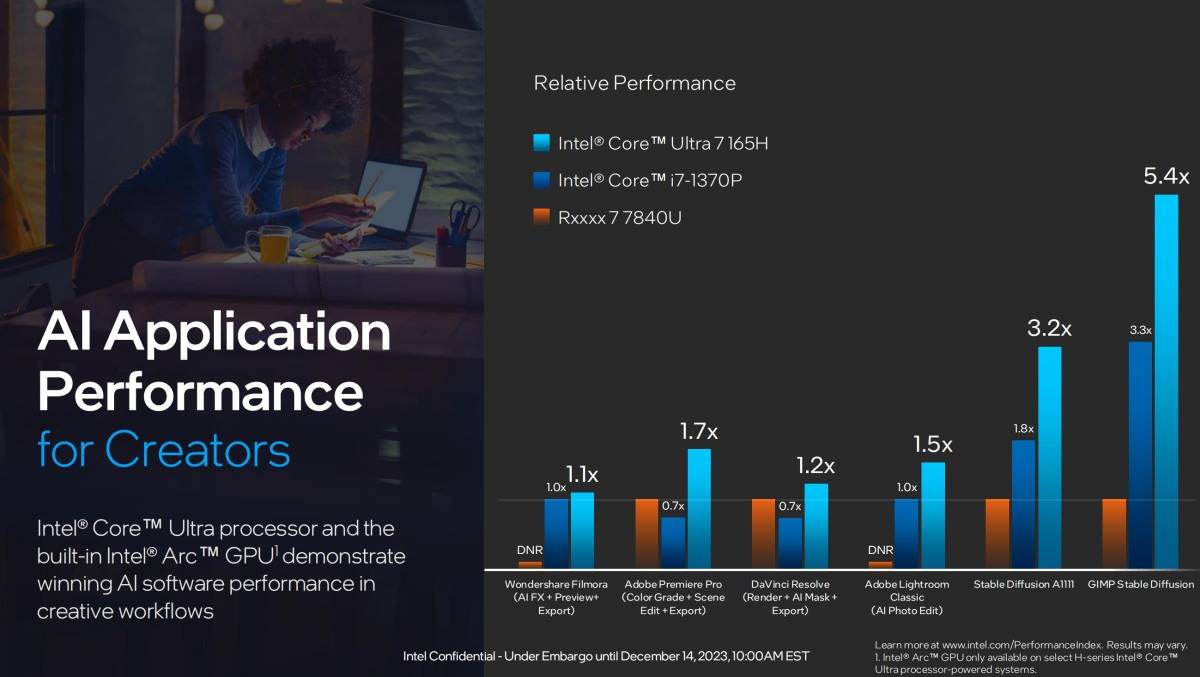

依旧是对比隔壁 AMD 7840U 处理器,英特尔表示酷睿 Ultra 7 165H 整体的 AI 运算能力不仅大胜自家上代产品酷睿 i7-1370P,更是碾压 AMD 7840U。

举个实际应用的例子,英特尔和字节跳动旗下的视频剪辑工具剪映一起优化了用户高频使用的「智能抠像」功能,在把这个功能的计算需求切换到第一代酷睿 Ultra 产品的 NPU 之后,我们发现,处理视频素材时不仅耗时降低,功耗也降低了,这个时候空余出来的 CPU 和 GPU 算力就可以用在其他的剪辑需求上。

因而,所谓 AI PC,不仅是能更好地运行 AI 功能,也能让效率提升,功耗降低。

第二层含义,像通义千问这样的大模型,能干啥?

现在我们已经可以在 PC 上进行百花齐放的 AI 操作,包括但不限于,文生文、文生图、文生音乐,还有 AI 抠图、手势识别、动作捕捉,更细节地还有 AI 配音变声、视频会议眼神矫正等等。

其中有一些基于大语言模型的是全新体验,有一些是早就可以在 PC 上实现的,比如 10 代酷睿就率先引入了 AI 性能的支持,可以为 PC 带来自动图像增强、视频分辨率增强、智能降噪等 AI 功能。

大语言模型技术被认为是通往通用型人工智能(AGI,Artificial General Intelligence)的道路,AGI 是指一种具备与人类相似的广泛智能水平和能力的人工智能系统,相较之下,目前大多数人工智能系统专注于特定任务或领域。

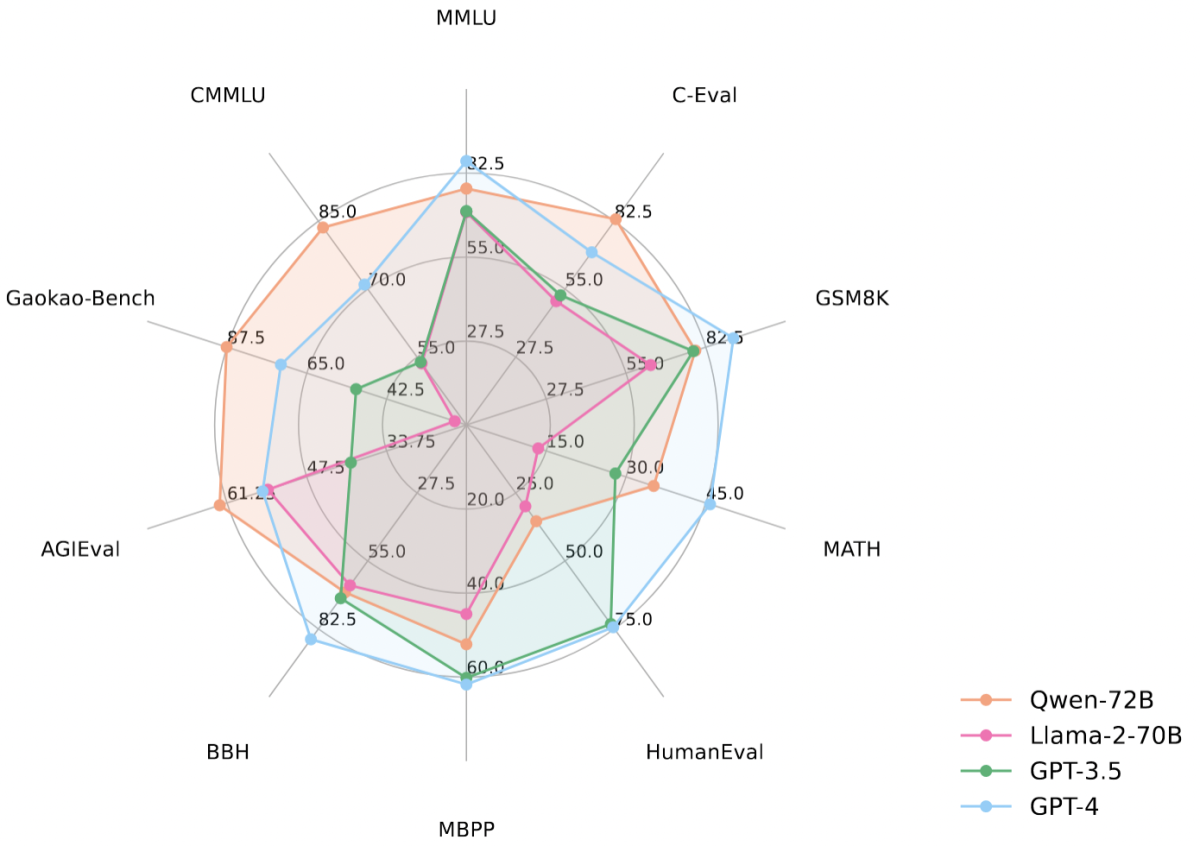

在这个前提下,阿里云刚刚开源的通义千问 720 亿参数模型(Qwen-72B)可以称之为目前最强开源大模型,Qwen-72B 在 10 个权威基准测评创下开源模型最优成绩,性能超越开源标杆 Llama 2-70B 和大部分商用闭源模型,已经具有一定的通用能力了。

基于阿里云开源的 Qwen-72B,Qwen-14B、Qwen-7B、Qwen-1.8B 四款大语言模型,以及视觉理解大模型 Qwen-VL、音频理解大模型 Qwen-Audio,阿里云实现了「全尺寸、全模态」的开源。

这意味着对于各行各业的开发者来说,这些开源大模型能够有多种选择套餐,PC、手机,甚至是 IoT 设备的端侧不熟都有可能。

通义千问大模型部署在适配英特尔酷睿 Ultra 平台,未来可在 PC 等端侧部署便是其中一种成为现实的可能。

另外,华东理工大学 X-D Lab 团队基于通义千问开源模型 Qwen-7B 和 Qwen-14B 开发了多款行业大模型,包括心理健康大模型 MindChat(漫谈)、医疗健康大模型 Sunsimiao(孙思邈)、教育/考试大模型 GradChat(锦鲤)等等。

浙江大学联合高等教育出版社基于 Qwen-7B 开发了智海-三乐教育垂直大模型,已在全国 12 所高校应用,可提供智能问答、试题生成、学习导航、教学评估等能力,模型已在阿里云灵积平台对外提供服务,一行代码即可调用。

脱离比特世界,在现实世界,浙江有鹿机器人科技有限公司在路面清洁机器人中集成了 Qwen-7B,使机器人能以自然语言与用户进行实时交互,理解用户提出的需求,将用户的高层指令进行分析和拆解,做高层的逻辑分析和任务规划,完成清洁任务。

简言之,AI 的舞台不仅仅在于 PC,PC 也不仅仅只有 AI 应用,但它们之间开始产生巨大的交集,产生将改变我们 PC 使用习惯的场景。

画图,是用数位板加压感笔进行创作,还是用文生图?

写作,是用键盘一个字一个字敲出来,还是用文生文?

这些问题已经显现,每一个拥有 AI PC 的用户,也将逐渐面临选择和使用习惯的转变。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

from 爱范儿 https://ift.tt/Knk75QD

via IFTTT

没有评论:

发表评论